Más de 4000 científicos explicaron por qué la IA impactará nuestra vida en poco tiempo

Escuchá esta nota

EL DIARIO digital

minutos

De manera continua, estamos entre noticias que hablan de los beneficios y los riesgos de la inteligencia artificial, un vaivén que fue profundizado en una investigación realizada por University College London (UCL) en la que se consultaron a científicos que trabajan en IA para contrarrestar lo que piensan los ciudadanos en Reino Unido y las opiniones demostraron una sensación más positiva sobre esta tecnología.

El estudio contó con 4.260 investigadores de diferentes países, evaluando los beneficios y riesgos de la IA, qué valores guían su trabajo y qué papel le asignan al público en el desarrollo de esta tecnología.

Qué opinan los científicos sobre el impacto que tendría la IA en la humanidad

Uno de los hallazgos centrales del informe, titulado Visions, Values, Voices, revela una marcada diferencia entre el nivel de optimismo de los investigadores respecto al de la ciudadanía.

Mientras que el 87?% de los científicos encuestados considera que los beneficios de la IA superan o se equilibran con sus riesgos, apenas el 57?% de los ciudadanos del Reino Unido comparten esa visión. Solo un 9?% de los expertos cree que los riesgos son mayores que los beneficios, en contraste con el 28?% del público británico.

No obstante, esta brecha se reduce cuando se trata de identificar los posibles efectos negativos de la IA. Investigadores y ciudadanos coinciden en señalar la desinformación, el uso indebido de datos personales y el cibercrimen como las principales amenazas.

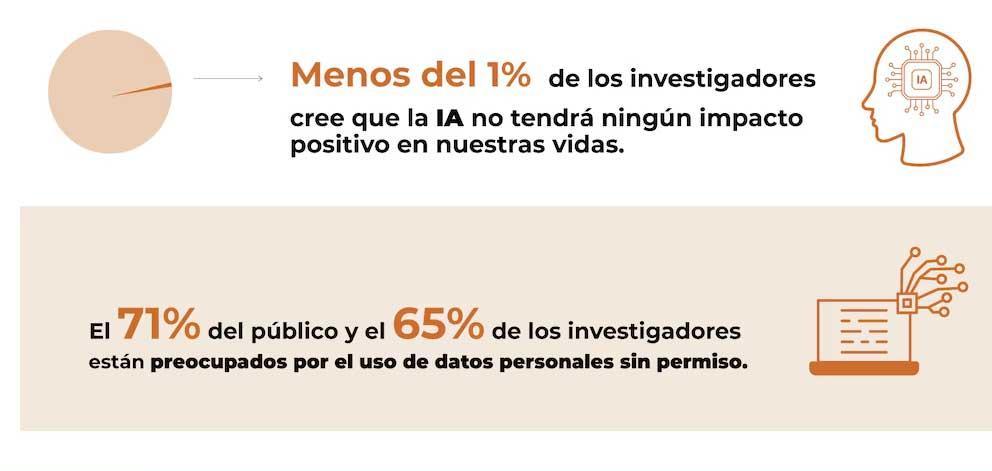

El 77?% de los científicos y el 68?% de los encuestados por la Oficina Nacional de Estadísticas del Reino Unido consideran que la IA agrava el problema de las noticias falsas. En relación con el uso de datos sin consentimiento, 65?% de los investigadores y 71?% del público expresan preocupación.

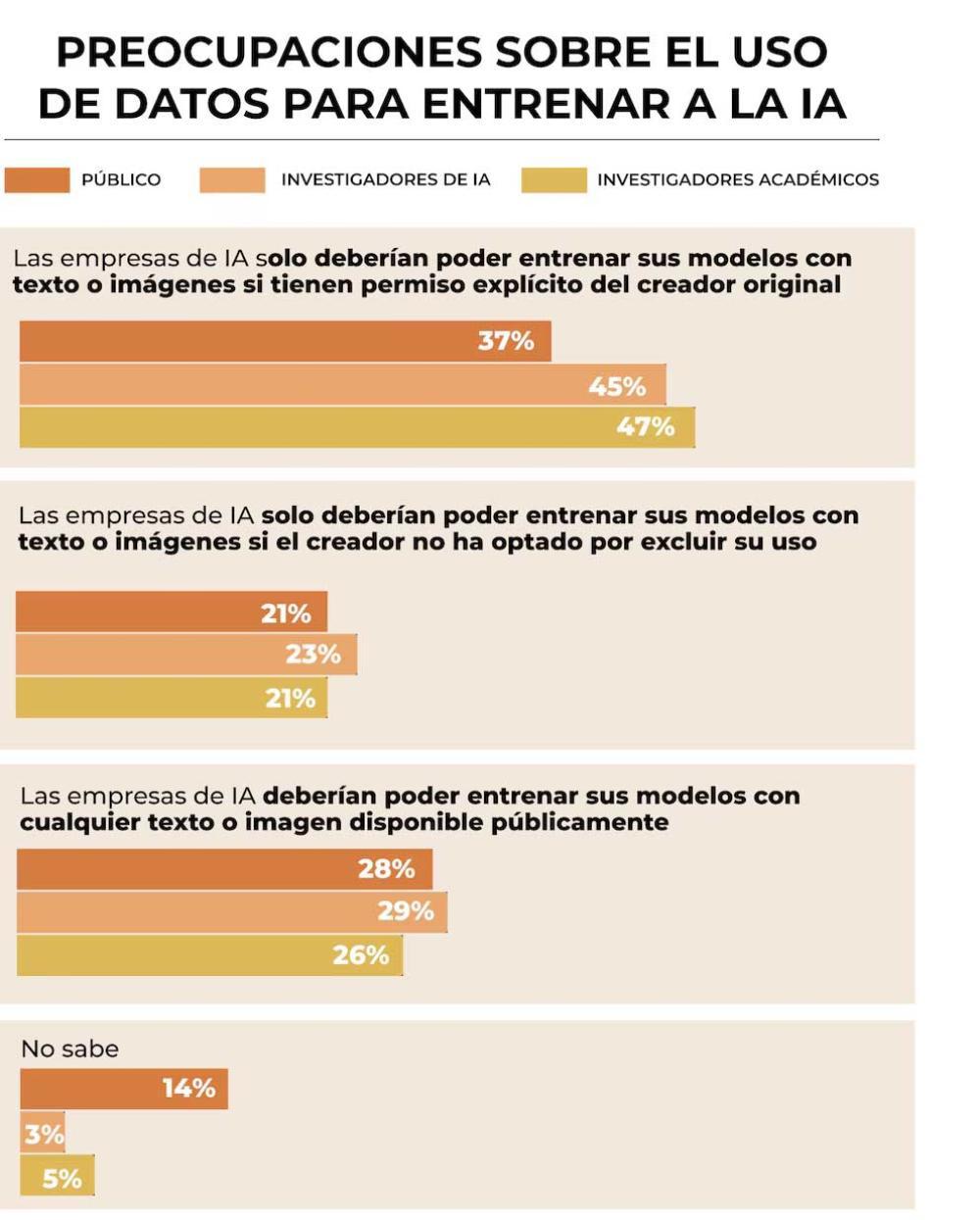

El entrenamiento de modelos de IA con datos extraídos de manera masiva de Internet, incluyendo obras literarias y artículos científicos, ha sido objeto de controversia. La encuesta indica que solo uno de cada cuatro científicos considera aceptable entrenar modelos con datos públicos sin consentimiento explícito. En cambio, casi la mitad opina que debe requerirse un permiso claro de los autores o usuarios.

Cuáles son los riesgos que traería la IA

Lejos de sostener una visión ingenuamente entusiasta, los científicos consultados manifestaron un alto nivel de preocupación por algunos efectos nocivos ya visibles en el despliegue de sistemas de inteligencia artificial. La mayoría señaló como amenazas concretas el uso de la IA para diseminar desinformación, su rol en delitos informáticos y el tratamiento indebido de datos personales.

El 77?% de los investigadores afirmó que la IA contribuye a intensificar el problema de la desinformación, una opinión que también comparte el 68?% del público británico. La capacidad de los algoritmos para generar y propagar contenido falso, especialmente en redes sociales, plantea desafíos urgentes para la integridad de la información en sociedades democráticas.

Además, el uso no autorizado de datos personales aparece como uno de los puntos más sensibles. El 65?% de los científicos encuestados expresó inquietud sobre cómo las empresas tecnológicas recolectan y utilizan la información privada de las personas sin su consentimiento. En este aspecto, la visión de los investigadores resulta incluso más crítica que la de algunos gobiernos que proponen mecanismos de exclusión voluntaria ("opt-out") para el uso de datos con fines de entrenamiento algorítmico.

Según explicó Cian O'Donovan, autor principal del estudio, "las opiniones de los investigadores chocan con ciertas propuestas regulatorias, como las del gobierno británico, que apuntan a permitir el uso de obras protegidas por derechos de autor salvo que los autores se opongan expresamente".

Qué opinan los investigadores sobre el uso de datos y la regulación de la IA

Una de las preguntas clave del estudio fue si las empresas de IA deberían poder entrenar sus modelos con cualquier texto o imagen disponibles públicamente. Solo el 25?% de los científicos respondió afirmativamente. En cambio, casi la mitad sostuvo que debería requerirse una autorización explícita del autor o propietario de esos contenidos.

Este hallazgo pone en entredicho la práctica habitual de muchas compañías tecnológicas que han utilizado sin consentimiento miles de millones de palabras de libros, artículos científicos, publicaciones en redes y otros materiales disponibles en línea para desarrollar modelos de lenguaje como los que actualmente dominan el mercado. Para muchos investigadores, esta lógica de apropiación masiva representa un conflicto ético que debe ser atendido cuanto antes.

El informe también indagó quiénes deberían ser responsables de garantizar el uso seguro de la inteligencia artificial. Los investigadores señalaron principalmente a las empresas desarrolladoras, los gobiernos y los organismos internacionales. En contraste, el público británico se inclinó por la creación de reguladores independientes con participación ciudadana.

En cuanto a las expectativas de desarrollo futuro, solo el 29?% de los expertos consideró que la IA debería avanzar lo más rápido posible. El resto se inclinó por una aproximación más cautelosa, priorizando el análisis de riesgos antes que la aceleración de la innovación.

Asimismo, apenas uno de cada cinco investigadores cree firmemente que el desarrollo de una inteligencia artificial general (AGI) es inevitable, lo cual marca una clara distancia respecto al entusiasmo de ciertos actores de la industria tecnológica que afirman estar cerca de alcanzar ese objetivo.